作者: 日期:2018-06-22 人气:627

对于搜索引擎来说,要抓取互联网上所有的网页几乎是不可能的。那么蜘蛛是怎么抓取的呢?今天我们就继续来讨论:搜索引擎的工作原理还有哪些?一起来看看!

从目前公布的数据来看,容量最大的搜索引擎也不过是抓取了整个网页数量的40%左右。这其中的原因一方面是抓取技术的瓶颈,无法遍历所有的网页,有许多网页无法从其他网页的链接中找到;另一方面是存储技术和处理技术的问题。如果按照每个页面的平均大小为20K计算(包含图片),100亿网页的容量是100-2000G字节。即使能过存储,下载也存在问题(按照一台机器每秒下载20K计算,需要240台机器不停地下载一年时间,才能把所有网页下载完毕)。

同时,由于数据量太大,在提供搜索时也会有效率方面的影响。因此,许多搜索引擎的搜索引擎蜘蛛只是抓取哪些重要的网页,而在抓取的时候,评价重要性主要的依据是某个网页的链接深度。

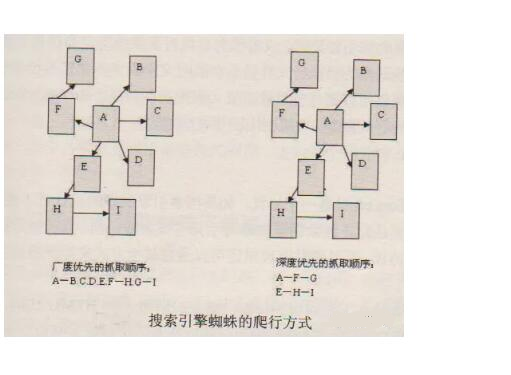

在抓取网页的时候,搜索引擎蜘蛛一般有两种策略:广度优先和深度优先。广度优先是指搜索引擎蜘蛛会先抓取起始网页中链接的所有网页,然后再选择其中一个链接网页,继续花去在此网页中链接的所有网页。这是最常用的方式,因为这个方法可以让搜索引擎并行处理,提高其抓取速度。深度优先是指搜索引擎蜘蛛会从起始页开始,一个链接一个链接跟踪下去,处理完这条线路之后再转入下一个起始页,继续跟踪链接。这个方法有个优点是搜索引擎蜘蛛在设计的时候比较容易。

由于不可能抓取所有的网页,有些搜索引擎蜘蛛对一些不太重要的网站,设置了访问的层数如下图,A为起始网页,属于0层,B、C、D、E、F属于第1层,G、H属于第2层,I属于第3层。如果搜索引擎蜘蛛设置的访问层数为2的话,网页I是不会被访问到的。这也让有些网站上的一部分网页能够在搜索引擎上搜索到,另外一部分不能被搜索到。对于网站设计者来说,扁平化的网站结构设计有助于搜索引擎抓取其更多的网页。

搜索引擎蜘蛛在访问网站网页的时候,经常会遇到加密数据和为网页权限的问题,有些网页是需要有会员权限才能访问的。当然,网站的所有者可以通过协议让搜索引擎只注意不去抓取,但对于一些出售报告的网站,他们希望搜索引擎能搜索到他们的报告,但又不能完全免费地让搜索者查看,这样就需要给搜索引擎蜘蛛提供相应的用户名和密码。搜索引擎蜘蛛可以通过所给的权限对这些网页进行网页抓取,从而提供搜索。而当搜索者点击查看该网页的时候,同样需要搜索者提供相应的权限验证。

最先剖析要散播的目的客户人群的陋习与话动范畴; 精心安排合乎网民爱好的论坛推广时件或话动; 积淀论谈有关社交圈子資源,会对进行论坛推广出示挺大适用; 搞好数据分析,以知道论坛推广的成功失败之举,加以改进。

人们常常会遇上有些人做论坛推广的当时,以便能短期内内看到作用,就在每个论谈网站上注冊很多的id,花两三天的時间就把各大论坛上贴的浓浓的全是软广,可是隔过段时间回来看,以前公布的全部贴子都被删的干净整洁,情况严重将会注冊的id也被封的干净整洁,而针对这类人只有说成爱好者的论坛推广技巧了。在进到这一议论以前,人们看一下自身是不是存有那样的难

联系电话:15314649589

添加微信:feishangdaren

工作时间:9:00-18:00 (工作日)

意见建议:1415941@qq.com